Stellar Evolution - PowerPoint PPT Presentation

1 / 25

Title:

Stellar Evolution

Description:

GENE Ein massiv paralleler Code zur Berechnung von turbulenten Str mungen in Fusionsplasmen Priv.-Doz. Dr. Frank Jenko Nachwuchsgruppe Theorie und Ab-initio ... – PowerPoint PPT presentation

Number of Views:77

Avg rating:3.0/5.0

Title: Stellar Evolution

1

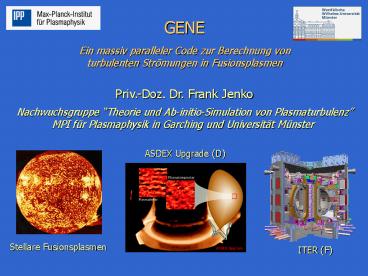

GENE Ein massiv paralleler Code zur Berechnung

von turbulenten Strömungen in Fusionsplasmen Priv

.-Doz. Dr. Frank Jenko Nachwuchsgruppe Theorie

und Ab-initio-Simulation von Plasmaturbulenz MPI

für Plasmaphysik in Garching und Universität

Münster

ASDEX Upgrade (D)

Stellare Fusionsplasmen

ITER (F)

2

Was sind die 10 größten ungelösten Probleme in

der Physik?

- Umfrage des Institute of Physics (Britische

Physikervereinigung) - Fusionsenergie

- Turbulenz

- Komplexität

(Ausgabe 12/1999)

Diesen Grand Challenges ist dieses Projekt

gewidmet

3

Turbulenzforschung

Turbulente Strömungen sind allgegenwärtig

aber bis heute nicht wirklich verstanden!

4

Fusionsforschung und Plasmaturbulenz

- 100 Mio Grad heißes, ionisiertes

- Gas (Plasma) in torusförmigen

- magnetischen Käfigen

- Energieverlustrate liegt i.A. um

- etliche Größenordnungen über

- den naiven Erwartungen

Plasmaturbulenz ist ein/das Kernproblem der

Fusionsforschung Ziel Verständnis und Kontrolle

5

Turbulenzinduzierter Transport (Simulation)

6

Direkte numerische Simulation mit

GENE Physikalische Grundlagen Verwendete

Algorithmen Parallelisierungsstrategie Ergebniss

e und Herausforderungen

7

Konzeptioneller Ansatz

Komplexe Phänomene

DNS (GENE)

einfache Modelle

Qualitatives Verständnis (fundamentale Prozesse)

Quantitatives Verständnis (direkter Vergleich mit

dem Experiment)

8

Einfaches 2D-Flüssigkeitsmodell

Hasegawa-Mima-Gleichung

- minimales Modell für Plasmamikroturbulenz

- 2D-Gleichung für das elektrostatische Potential

? - identisch mit der Charney-Gleichung (Geophysik)

- eng verwandt mit der 2D-Navier-Stokes-Gleichung

Varianten dieser Gleichung liegen vielen Studien

zugrunde sie ist das Herzstück

aufwändigerer/realistischerer Modelle.

9

Kinetische Beschreibung stossarmer Plasmen

Dünne, heisse Plasmen sind fast stossfrei

Vlasov-Maxwell-Gleichungen

Nichtlineare Integro-Differentialgleichungen in

32 Dimensionen

10

Die nichtlinearen gyrokinetischen Gleichungen

X Position des Gyrozentrums V? parallele

Geschwindigkeit µ magnetisches Moment

Entsprechende Feldgleichungen

11

Direkte numerische Simulation mit

GENE Physikalische Grundlagen Verwendete

Algorithmen Parallelisierungsstrategie Ergebniss

e und Herausforderungen

12

Effiziente Nutzung von Höchstleistungsrechnern

- Mathematische Formulierung des Problems

- Mittelung über die schnelle Gyrationsbewegung

eliminiert kleine - und irrelevante Raum-Zeit-Skalen spart viele

Größenordnungen - Anpassung des Koordinatensystems an die

räumliche Struktur der - turbulenten Fluktuationen, d.h. an das

Hintergrund-Magnetfeld - spart etwa 2-3 Größenordnungen

13

Wahl des Algorithmus

- Wichtige Auswahlkriterien

- Stabilität bzw. Robustheit

- möglichst geringe Komplexität

- gute Effizienz und Parallelisierbarkeit

- Algorithmische Alternativen

- Particle-in-Cell-Methoden

- hervorragend parallelisierbar

- numerisches Rauschen

- Semi-Lagrange-Methoden

- kein numerisches Rauschen

- i.d.R. nur schwer parallelisierbar

- Gitter-Methoden

- kein numerisches Rauschen

- Effizienz und Parallelisierbarkeit OK

14

Angewandte CFD-Methoden

FJ und Tilman Dannert (1999-2005)

- Kinetische Gleichung (eine für jede

Teilchenspezies) - x-Richtung (radial) kompakte finite Differenzen

(quasispektral) - y-Richtung (toroidal) pseudospektral

(Axialsymmetrie des Torus) - z-Richtung (poloidal) finite Differenzen vom

upwind-Typ - v_parallel-Richtung zentrierte finite

Differenzen - µ-Richtung tritt nur als Parameter auf

- Typisches Phasenraum-Gitter bei minimalem

Simulationsvolumen - 128 x 64 x 32 x 32 x 8 Punkte ( Bevölkerung der

BRD) - Feldlöser

- Berechnung der Quellterme erfordert

Geschwindigkeitsraum-Integration - Lösung der 2D-Poisson/Helmholtz-Gleichungen im

x-y-Raum durch FFTs - Zeitschrittverfahren

- Explizites Runge-Kutta-Verfahren 3. Ordnung

(Heun-Verfahren)

15

Wahl des Zeitschrittverfahrens

Linearisiertes (und reduziertes)

Problem Phasenraum-Diskretisierung liefert

Matrix-Gleichung

Stabilitätsbereiche von ERK-Verfahren

Lage der EW in der komplexen Ebene

Lineare Stabilität erfordert ein ERK-Verfahren

von mindestens 3. Ordnung

16

Direkte numerische Simulation mit

GENE Physikalische Grundlagen Verwendete

Algorithmen Parallelisierungsstrategie Ergebniss

e und Herausforderungen

17

Parallelisierung und Rechnerarchitektur

Im wesentlichen zwei Familien

Shared memory (Symmetric Multi Processing) OpenMP

(Open Multi Processing)

Distributed memory (Clusters) MPI (Message

Passing Interface)

IBM-Regatta-System am Rechenzentrum Garching

25 Knoten à 64/256 GB 166.4 GFlop/s

(peak)

Zwei Alternativen 1) Nur MPI 2) Mischung aus

MPI und OpenMP

18

Parallelisierungsstrategie bei GENE

- Lokale und nichtlokale Operatoren

- x-Richtung FFTs, kompakte finite Differenzen

- y-Richtung FFTs

- z-Richtung finite Differenzen

- v-Raum Integration

- Gemischte Parallelisierung

- MPI-Prozesse z, y, µ (Wahlmöglichkeit)

- OpenMP Rest

SMP-Knoten 1 MPI-Prozess OpenMP

SMP-Knoten 1 MPI-Prozess OpenMP

SMP-Knoten 1 MPI-Prozess OpenMP

SMP-Knoten 1 MPI-Prozess OpenMP

Erzielte Effizienz bis etwa 15 des

theoretischen Maximums

19

Direkte numerische Simulation mit

GENE Physikalische Grundlagen Verwendete

Algorithmen Parallelisierungsstrategie Ergebniss

e und Herausforderungen

20

Turbulenzantrieb durch Mikroinstabilitäten

- Wichtige Mikroinstabilitäten

- Ion temperature gradient (ITG) modes

- Electron temperature gradient (ETG) modes

- Trapped electron modes

Im linearen Bereich sind ITG- und ETG-Modes

isomorph. Im nichtlinearen Bereich könnte das

bedeuten

21

DNS von ETG-Turbulenz

Strukturbildung Dominanz von radial

elongierten Wirbeln (streamers) Turbulenter

Transport In Gegenwart von streamers kann der

Transport um mehr als eine Größenordnung

steigen Theoretische Erklärung FJ et al.,

Phys. Plasmas 2000 W. Dorland, FJ et al., PRL

2000 FJ and W. Dorland, PRL 2002 FJ, Phys. Lett.

A 2005

Jenko Kendl 2002

22

Plasmaturbulenz als ein Multiskalenproblem

spectra of (log-log plot)

edge pars

nonlinear cross-scale coupling

Jenko 2004

Verletzung des Superpositionsprinzips!

23

Globale Rechnungen (ITER)

Eine globale Turbulenzsimulation für ITER wird im

Jahr 2015 auf einem 10 PFlop/s-Rechner etwa eine

Woche dauern

24

DEISA Extreme Computing Initiative

Distributed European Infrastructure for

Supercomputing Applications www.deisa.org Eines

von 20 EU-Projekten in 2005/2006

GYROKINETICS The ultimate goal of this

effort is to create a 'virtual fusion

plasma which can be used to predict and optimize

the performance of future tokamaks and

stellarators.

25

DanksagungTilman DannertReinhard TismaMehr

Informationwww.ipp.mpg.de/fsj